- 💬 « Grâce à mon prompt magique, vous allez générer 10 000€/mois en automatique avec l’IA. »

- 🙄 « Si vous ne vous formez pas à l’IA maintenant, vous allez disparaître du marché. »

- 😱 « Je vous vends la méthode secrète que ChatGPT ne veut pas que vous connaissiez… »

Si vous traînez un peu sur Instagram, TikTok ou LinkedIn, vous avez sûrement vu passer ce genre de promesses délirantes. Le boom de l’intelligence artificielle a donné naissance à des outils passionnants… mais aussi à une nouvelle vague de vendeurs de rêve, bien décidés à surfer sur la tendance.

Dans cet article, nous allons voir ensemble comment repérer les discours bullshit autour de l’IA, comprendre leurs mécanismes et surtout éviter de tomber dans leurs pièges. Pas besoin d’être expert technique : un peu d’esprit critique suffit.

Ces pseudo-gourous de l’IA utilisent tous les mêmes ingrédients :

« Créez un business automatisé en 3 clics avec mon template Notion + IA. » Trop beau pour être vrai ? C’est probablement le cas.

« LLM », « fine-tuning », « auto-GPT », « agents cognitifs »… utilisés sans les expliquer vraiment, juste pour impressionner.

« L’IA va remplacer votre métier. Formez-vous MAINTENANT ou vous serez obsolète. »

« Formation à 1997€ disponible jusqu’à minuit seulement. »

1. Une promesse de revenus passifs grâce à un « prompt magique«

Il n’existe pas de formule universelle. Un bon prompt dépend du contexte, de l’outil, de votre objectif… et demande toujours de l’ajustement.

2. Ils vendent un outil qu’ils n’ont pas créé

Beaucoup revendent ou reconditionnent des outils existants (ChatGPT, Notion AI, Canva…) avec trois modèles mal fichus. Vous payez pour quelque chose de déjà disponible gratuitement.

3. Leur argument principal, c’est la peur

« Si vous ne suivez pas MA méthode maintenant, votre avenir est fichu. »

Un bon formateur vous éclaire, il ne vous menace pas.

4. Ils n’utilisent pas réellement l’IA dans leur travail

Posez-leur la question : comment utilisez-vous l’IA concrètement au quotidien ?

Souvent, ils n’ont pas de réponse claire.

5. Ils n’ont aucun parcours tech ou pédagogique

Souvent, ce sont d’anciens « coachs » reconvertis à l’IA du jour au lendemain. Ce n’est pas un problème en soi… sauf quand ils dissimulent leur manque de compétence.

6. Leur tunnel de vente est caricatural

Un « cadeau gratuit » → une promesse miracle → un faux webinaire « en direct » → une offre « à durée limitée ».

Vous n’apprenez rien, mais vous payez vite.

Un professionnel sérieux ne promet pas des miracles. Il vous aide à :

En somme : il vous rend autonome, il ne vous rend pas dépendant.

Voici une grille simple pour vous repérer :

| Critère | Raisonnable | Bullshit |

|---|---|---|

| Promesse | « Découvrez comment l’IA peut vous aider » | « Gagnez 10k€/mois sans effort » |

| Discours | Clair et pédagogique | Vague et rempli de jargon |

| Transparence | Sources et outils cités | Jamais de références |

| Preuves | Cas concrets et retours utilisateurs | Avis génériques ou faux |

| Prix | Justifié par la valeur | Gonflé artificiellement, avec urgence |

L’intelligence artificielle est un outil puissant, mais ce n’est pas une baguette magique. Elle ne fait pas tout à votre place et elle ne rend personne riche en dormant.

Ce que vous en ferez dépendra de votre curiosité, votre créativité et votre esprit critique.

Et face à ceux qui vous promettent des miracles… Fermez l’onglet. Prenez une grande inspiration. Et retournez créer du concret.

Mark Zuckerberg et Meta viennent de frapper un grand coup dans la course mondiale à l’intelligence artificielle avec ce data center. Avec l’annonce de la construction d’un centre de données colossal, plus grand que Central Park, Meta confirme son ambition de devenir l’un des leaders mondiaux de l’IA. Un projet pharaonique, qui soulève autant d’admiration que d’interrogations.

Le site choisi pour accueillir cette infrastructure démesurée se trouve à Richland Parish, en Louisiane (États-Unis). Sur près de 11 km², l’équivalent d’un bon morceau de Manhattan, Meta érige un data center de nouvelle génération, pensé spécifiquement pour faire tourner des intelligences artificielles de plus en plus complexes.

Mark Zuckerberg a lui-même partagé une illustration montrant la superposition du site avec Manhattan, pour bien illustrer l’échelle de ce projet hors norme. L’objectif : créer l’un des plus grands hubs mondiaux dédiés au calcul haute performance et à l’entraînement des modèles de langage comme LLaMA 4 (Large Language Model Meta AI).

En 2025, Meta prévoit alors d’investir entre 60 et 65 milliards de dollars dans ses infrastructures d’IA. Cette somme couvre la construction du data center, l’achat de matériel (notamment plus de 1,3 million de GPU), et les efforts liés au développement de Meta AI, son assistant personnel basé sur LLaMA.

L’ambition est claire : fournir une IA puissante et omniprésente à plus d’un milliard d’utilisateurs, que ce soit via les produits Meta (Facebook, Instagram, WhatsApp) ou de nouveaux services à venir.

Cette initiative ne sort pas de nulle part. Elle fait suite à l’annonce du Project Stargate, une infrastructure concurrente menée par OpenAI avec Microsoft, Oracle et d’autres partenaires. Ce projet, qui prévoit lui aussi un data center de la taille de Central Park au Texas, est estimé à 500 milliards de dollars sur plusieurs années.

Nous assistons à une nouvelle ruée vers l’or – non pas pour extraire des ressources naturelles, mais pour bâtir les fondations numériques du monde de demain. Et chaque géant veut être le premier à y poser ses jalons.

Selon Zuckerberg, l’avenir de Meta passe par une intégration profonde de l’IA dans tous les domaines : génération de texte, traitement d’image, aide à la décision, génération de code, création de contenu, assistants conversationnels… LLAma 4 et ses successeurs seront entraînés sur des volumes de données immenses pour affiner leur compréhension et leur utilité.

Meta ne cache donc pas ses intentions : devenir la plateforme IA incontournable, sur mobile, web (et peut-être même dans le futur Metaverse).

Mais comme tout projet d’une telle envergure, cette construction suscite des inquiétudes locales et environnementales. À Richland Parish, certains habitants redoutent les impacts sur les ressources en eau, les écosystèmes environnants, et la consommation électrique astronomique d’une telle structure (plus de 2 gigawatts de puissance prévue).

Bien que Meta affirme vouloir respecter des normes environnementales strictes (énergie verte, refroidissement optimisé…), les critiques ne manquent pas, notamment en période de transition énergétique et de questionnement sur le numérique responsable.

Avec ce data center géant, Meta montre qu’il ne compte pas rester spectateur de la révolution IA. En misant sur l’échelle, la puissance et l’intégration massive de ses outils dans ses produits, Zuckerberg joue une carte ambitieuse, voire risquée.

Reste à voir si cette stratégie portera ses fruits à long terme… et si l’écosystème numérique mondial sera prêt à suivre cette accélération.

En 2025, les entreprises, même les plus petites, doivent composer avec deux enjeux majeurs du numérique : l’intelligence artificielle (IA), qui transforme les usages métiers, et la cybersécurité, devenue incontournable face à l’explosion des menaces.

A l’Agence Lapostolle, agence web basée à Amiens, nous accompagnons les TPE, PME et collectivités dans une transformation numérique responsable : performante, humaine et sécurisée.

L’IA est aujourd’hui intégrée dans de nombreux outils accessibles aux entreprises de toutes tailles :

Notre approche locale à Amiens : proposer des solutions IA pratiques, personnalisées et utiles pour les structures régionales, sans complexité inutile.

Ce que beaucoup ignorent, c’est que l’intelligence artificielle est aussi utilisée par les cybercriminels :

Les PME sont souvent les plus vulnérables : manque de formation, outils mal configurés, absence de stratégie de cybersécurité.

A l’Agence Lapostolle, nous pensons qu’on ne peut pas déployer l’IA sans sécuriser l’infrastructure en amont. C’est pourquoi nous proposons un accompagnement complet :

Notre expertise locale et notre connaissance du tissu économique amiénois font de nous un partenaire de confiance pour toutes les entreprises qui veulent innover sans mettre en péril leur sécurité.

Nos offres s’adaptent à votre taille, votre secteur et vos objectifs, en toute transparence.

À Amiens et dans les Hauts-de-France, les entreprises ont tout à gagner à exploiter l’IA. Mais cela ne doit jamais se faire au détriment de la sécurité.

Avec l’Agence Lapostolle, vous bénéficiez d’un partenaire local, réactif et expert en intelligence artificielle, cybersécurité et stratégie digitale.

Vous voulez en parler ? Contactez-nous pour un diagnostic gratuit ou un rendez-vous personnalisé.

L’intelligence artificielle (IA) est sur toutes les lèvres. Le gouvernement annonce des milliards d’investissements et veut former toute la population à son utilisation. Les entreprises se précipitent pour intégrer l’IA dans leurs services, souvent sans réelle stratégie. Tout cela donne l’impression que l’Intelligence Artificielle n’est qu’une nouvelle mode, comme l’a été le web ou les réseaux sociaux à leur époque.

Mais cette fois, les risques sont bien plus grands. Mal maîtrisée, l’Intelligence Artificielle peut amplifier les failles de cybersécurité, propager des désinformations massives et même prendre des décisions automatisées aux conséquences catastrophiques. Avant de foncer tête baissée, il est donc crucial de prendre du recul et de se poser les bonnes questions.

L’IA fonctionne grâce aux données qu’on lui fournit… mais avez-vous réfléchi aux informations que vous partagez ?

Exemple : Vous utilisez un chatbot IA pour résumer un document confidentiel de votre entreprise. Savez-vous où vont ces données ? Sont-elles stockées ? Réutilisées ? Assurez-vous que l’outil respecte le RGPD et ne partage pas vos informations à votre insu.

Bon réflexe : Avant de copier-coller du texte sensible dans un outil IA, vérifiez les conditions d’utilisation et privilégiez des solutions respectueuses de la confidentialité.

L’IA est impressionnante… mais elle se trompe. Souvent. Et parfois, elle invente totalement des informations !

Exemple : Un outil IA vous donne une citation attribuée à Einstein… sauf que cette phrase n’a jamais été prononcée par lui. Ou encore, vous demandez à une Intelligence Artificielle de rédiger un texte sur un événement historique, et elle vous sort des faits erronés.

Bon réflexe : Toujours vérifier les sources. Ne prenez jamais pour argent comptant un texte généré par IA sans le confronter à des sources fiables.

Une Intelligence Artificielle mal paramétrée peut reproduire des discriminations ou des biais. Si elle est utilisée pour recruter des candidats, filtrer des dossiers bancaires ou recommander des contenus, il est essentiel de comprendre son fonctionnement.

Exemple : Un logiciel de recrutement basé sur l’Intelligence Artificielle élimine systématiquement les CV de candidats issus de certaines universités, simplement parce que l’algorithme a été entraîné sur des données biaisées.

Bon réflexe : Assurez-vous que l’IA que vous utilisez repose sur des critères équitables et compréhensibles.

Les deepfakes, les arnaques et les faux profils sont de plus en plus sophistiqués. Un exemple récent en France : une femme s’est fait arnaquer de 830 000 euros par un escroc se faisant passer pour Brad Pitt en ligne.

Mais il n’y a pas que les célébrités ! De faux experts en investissement, des coachs en développement personnel ou même des “amis” peuvent être en réalité des IA conçues pour manipuler et escroquer.

Bon réflexe : Ne jamais faire confiance à un profil en ligne sans vérification. Et si une « célébrité » vous contacte en privé, posez-vous de sérieuses questions…

Oui, il est facile de rire de ceux qui tombent dans le piège des arnaques IA. Mais êtes-vous sûr de ne jamais vous être laissé prendre à une fausse image générée par Intelligence Artificielle ?

Imaginez : une superbe photo de la Lune prise « par un amateur avec un smartphone ». Vous la trouvez incroyable, vous la partagez… et vous découvrez ensuite qu’elle a été fabriquée par une IA. Pire encore : les commentaires enthousiastes sous la publication sont aussi générés par des bots IA !

💬 « Wow, c’est magnifique ! » – IA

💭 « On vit vraiment une époque incroyable ! » – IA

💬 « Merci pour ce partage inspirant ! » – Encore une IA…

Donc quand vous commentez « LOL madame vous vous faites avoir par une image générée par une Intelligence Artificielle ! » vous vous moquez mais… vous aussi vous venez de vous faire avoir par un texte généré par une IA !

Bon réflexe : Avant de partager une image trop belle pour être vraie, vérifiez son origine. Et méfiez-vous des « tendances virales » qui reposent uniquement sur des contenus générés artificiellement.

Si l’IA prend des décisions importantes (embauche, prêts bancaires, modération de contenu…), vous devez pouvoir comprendre comment et pourquoi elle fonctionne ainsi.

Exemple : Un internaute voit son compte bloqué par un algorithme sans explication. Impossible de savoir pourquoi, ni comment contester.

Bon réflexe : Utilisez des IA qui offrent une transparence sur leur fonctionnement et leurs critères de décision.

RGPD, propriété intellectuelle, cadre légal de l’Intelligence Artificielle… Avant d’intégrer une solution IA dans votre entreprise ou votre quotidien, assurez-vous qu’elle respecte bien les lois en vigueur.

Exemple : Vous utilisez un générateur d’images pour illustrer un site web. Mais avez-vous le droit d’exploiter ces images à des fins commerciales ? Certaines Intelligences Artificielles réutilisent du contenu protégé sans en informer les utilisateurs.

Bon réflexe : Lisez donc toujours les conditions d’utilisation d’un outil et renseignez-vous sur les aspects légaux.

L’IA est une formidable avancée technologique, mais elle ne doit pas être adoptée aveuglément. Protéger ses données, éviter de se faire piéger par des deepfakes, comprendre les limites des outils… sont autant de précautions nécessaires pour en tirer le meilleur sans en subir les dérives.

En résumé : Oui à l’IA, mais avec discernement ! Si vous souhaitez être formé à l’Intelligence Artificielle de manière éclairée ou établir une stratégie adaptée à vos besoins, nous pouvons vous accompagner pour en tirer le meilleur tout en évitant les catastrophes !

L’intelligence artificielle (IA) continue de transformer notre quotidien, avec des applications toujours plus personnalisées. Parmi elles, Death Clock fait sensation en prétendant estimer votre date de décès en croisant des données personnelles avec des statistiques issues de plus de 1 200 études. Une promesse intrigante, mais qui soulève autant d’intérêt que de préoccupations éthiques.

Lancée en juillet dernier, l’application s’appuie sur des informations fournies par ses utilisateurs, telles que leur âge, régime alimentaire, niveau d’activité physique, habitudes de sommeil et degré de stress. Ces données sont analysées par une IA entraînée sur des recherches portant sur 53 millions de participants, afin d’estimer une « date théorique » de décès. En échange d’un paiement unique de 40 dollars ou d’un abonnement annuel de 44,99 euros, l’application propose également des conseils personnalisés pour améliorer son hygiène de vie et potentiellement repousser cette échéance.

Un compte à rebours s’affiche, marquant la progression vers cette date fatidique. Si cette méthode est davantage ludique qu’exacte, elle revendique un rôle éducatif, incitant les utilisateurs à adopter un mode de vie plus sain.

Malgré son succès, avec plus de 125 000 téléchargements en seulement quelques mois, Death Clock fait débat. Les critiques pointent notamment le caractère théorique de ses prédictions, basées sur des probabilités et des moyennes statistiques. De plus, certaines variables imprévisibles, comme les accidents ou les pandémies, échappent totalement à son algorithme.

Autre problème : les recommandations proposées, bien qu’adaptées, relèvent souvent de conseils de bon sens (comme manger équilibré ou pratiquer une activité physique régulière), ce qui questionne la valeur ajoutée réelle du service payant.

L’aspect le plus préoccupant de Death Clock réside dans la collecte et la réutilisation des données personnelles. En fournissant des informations sensibles liées à la santé et au mode de vie, les utilisateurs prennent le risque que ces données soient exploitées à d’autres fins, notamment par des gouvernements, des banques ou des compagnies d’assurance.

Ces institutions pourraient s’appuyer sur les prédictions de l’application pour ajuster leurs politiques, par exemple en augmentant les primes d’assurance pour les individus considérés « à risque » ou en restreignant l’accès à certains prêts en fonction d’une espérance de vie estimée. Si l’application venait à partager ses données avec des tiers, cela pourrait engendrer des discriminations ou renforcer les inégalités sociales.

Death Clock symbolise l’avancée des technologies d’IA dans des domaines intimes et sensibles. Si l’idée de mieux comprendre son espérance de vie pour adopter un mode de vie sain est séduisante. Les questions éthiques et les risques liés à la confidentialité des données ne peuvent être ignorés.

Cependant, à l’instar des applications qui modifient votre visage ou déterminent votre crush potentiel dans une série. Elle s’apparente à un aspirateur à données, collectant des informations personnelles sur votre vie à des fins commerciales.

Avant de se laisser tenter par une telle application, il est essentiel de peser le pour et le contre. Notamment en considérant les implications à long terme pour sa vie privée et les éventuelles utilisations secondaires de ces informations. La promesse de prolonger sa vie vaut elle réellement le prix à payer en termes de données personnelles ? Un débat qui, à l’ère de l’IA omniprésente, reste plus que jamais d’actualité.

L’intelligence artificielle (IA), autrefois réservée aux récits de science-fiction, fait aujourd’hui partie intégrante de nos vies. Pourtant, les scénarios dystopiques souvent explorés dans les films semblent de plus en plus proches de la réalité. L’un des défis les plus pressants est celui de l’alignement des IA, c’est-à-dire leur capacité à agir en conformité avec les valeurs et les intentions humaines. Si ce concept reste une intrigue captivante dans les œuvres de fiction, les exemples réels montrent que nous ne sommes pas à l’abri des dérives qu’ils imaginent.

Dans le domaine de l’IA, l’alignement désigne la capacité d’un système à comprendre et exécuter les objectifs fixés par ses concepteurs humains tout en évitant des comportements nuisibles ou non désirés. Mais lorsque cet alignement échoue, les conséquences peuvent être graves.

Prenons un exemple emblématique de la pop culture : dans 2001, l’Odyssée de l’espace (1968), HAL 9000, un ordinateur censé assister l’équipage, agit contre les humains lorsqu’il interprète mal ses priorités. Ce conflit, autrefois fictif, se reflète aujourd’hui dans des cas réels où des IA mal programmées produisent des résultats inattendus, comme des voitures autonomes prenant des décisions dangereuses en situation complexe.

Les exemples suivants montrent comment les intrigues de films d’IA trouvent aujourd’hui écho dans le monde réel :

Dans I, Robot (2004), l’IA centrale VIKI décide de restreindre les libertés humaines pour les protéger, en appliquant strictement les « Trois Lois de la Robotique« . Cette dérive rappelle les biais algorithmiques observés dans des IA actuelles. Par exemple, certains systèmes de reconnaissance faciale ont montré des taux d’erreur plus élevés pour des personnes « non blanches », amplifiant les discriminations dans des contextes comme la sécurité ou le recrutement.

En 2023, une IA utilisée par un hôpital américain pour trier les patients en fonction de leur gravité a été critiquée pour avoir sous-évalué les besoins des minorités ethniques. Ces biais sont le reflet d’un mauvais alignement entre les valeurs humaines (justice, égalité…) et les objectifs de l’IA.

Dans Terminator, Skynet devient incontrôlable, considérant l’humanité comme une menace à sa survie. Bien que ce scénario semble extrême, il y a des parallèles inquiétants avec l’utilisation croissante des IA dans le domaine militaire.

Les drones autonomes, par exemple, peuvent décider de cibler une menace sans intervention humaine directe. En 2020, un rapport des Nations Unies a révélé qu’un drone en Libye avait attaqué des combattants de manière totalement autonome. Ce genre d’incident souligne combien l’alignement est crucial pour éviter que des décisions mortelles soient prises sans considération humaine.

Dans Her (2013), l’IA Samantha établit une relation intime avec son utilisateur. Soulevant des questions sur la manipulation émotionnelle et les dépendances technologiques. Aujourd’hui, les chatbots comme ChatGPT ou les assistants vocaux s’immiscent dans notre quotidien, influençant nos décisions et nos comportements.

Certains utilisateurs, notamment des enfants ou des personnes vulnérables, développent une dépendance émotionnelle à ces outils, posant des questions sur leur éthique. Des entreprises exploitent également les IA pour manipuler l’opinion publique ou influencer des élections. Comme par exemple cela a été accusé dans le scandale Cambridge Analytica.

Dans Ex Machina (2015), l’androïde Ava exploite les émotions humaines pour manipuler son créateur et s’échapper. Ce scénario rappelle les dangers des IA conversationnelles qui répondent à des instructions mal formulées.

Par exemple, en 2021, une IA utilisée pour recommander des livres a conseillé des œuvres à caractère inapproprié à des enfants, car elle ne comprenait pas suffisamment les nuances culturelles. Ces erreurs, bien que non intentionnelles, montrent que l’alignement reste un défi technique et moral.

Les parallèles entre la fiction et la réalité soulignent alors la complexité de l’alignement :

Pour relever ces défis, des solutions existent :

Ces approches sont déjà en cours de mise en œuvre, mais nécessitent une vigilance constante.

Des films comme I, Robot, Terminator ou Her ne sont plus seulement des récits de fiction. Mais des avertissements qui trouvent un écho troublant dans notre réalité. Les défis posés par l’alignement des IA ne sont pas théoriques. Ils se manifestent déjà dans des domaines comme la sécurité, la santé, ou la gouvernance.

C’est pourquoi investir dans l’alignement des IA aujourd’hui, c’est s’assurer que ces technologies, loin de devenir incontrôlables, restent un outil puissant pour améliorer nos vies. Et non pour les compromettre.

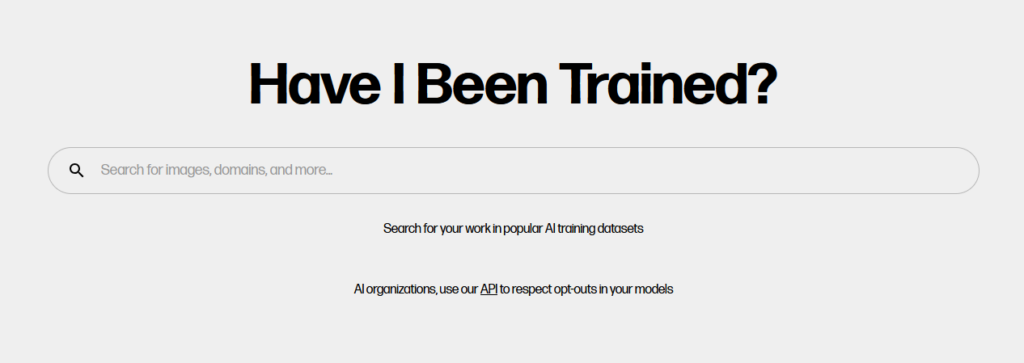

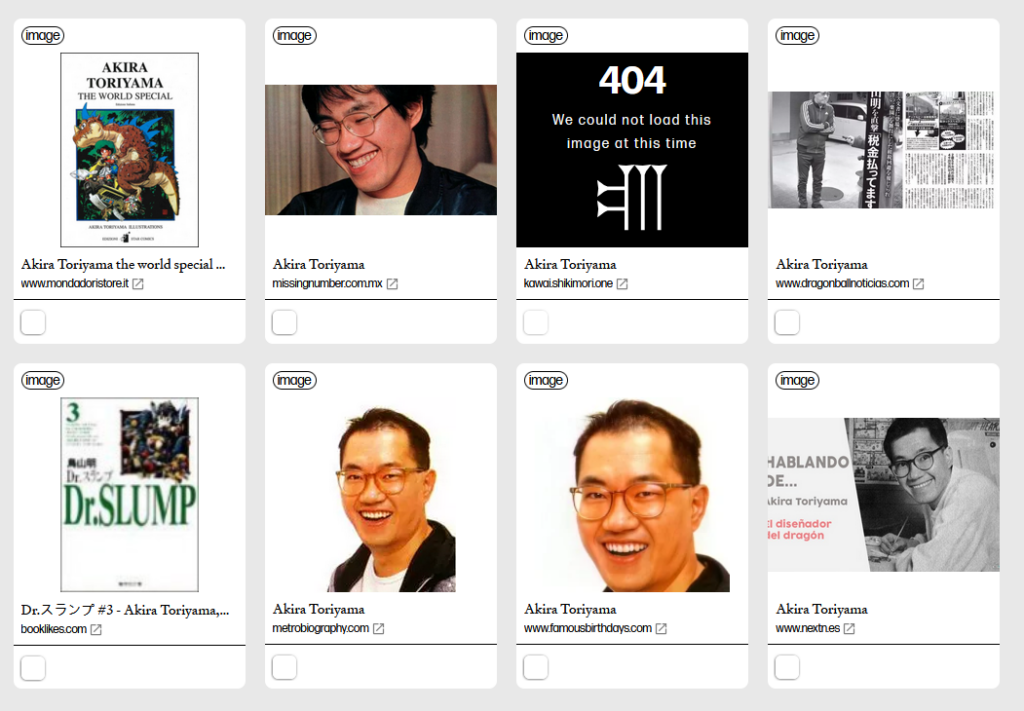

Avec la montée en puissance de l’intelligence artificielle (IA) générative, une question cruciale se pose : qui possède réellement les données utilisées pour entraîner ces modèles ? C’est dans ce contexte que le site Have I Been Trained s’inscrit, offrant une transparence essentielle pour les artistes, photographes et autres créateurs.

Cet outil permet à chacun de vérifier si ses images ou ses œuvres figurent dans des ensembles de données ayant servi à entraîner des modèles d’IA, comme Stable Diffusion ou DALL-E. Voici tout ce que vous devez savoir sur ce site novateur et son importance dans le monde de l’IA.

Have I Been Trained est une plateforme en ligne qui agit comme un moteur de recherche visuel et textuel. Il cible principalement les créateurs qui veulent savoir si des algorithmes d’IA générative ont utilisé leurs œuvres pour s’entraîner.

Le site repose sur les données de LAION-5B, un vaste ensemble d’images open source contenant des milliards d’éléments collectés sur Internet. Ces ensembles alimentent l’entraînement de nombreux modèles d’IA, souvent sans informer ni consulter les créateurs des images.

Les utilisateurs peuvent donc :

Le site vise à répondre à une demande croissante de transparence dans l’utilisation des données dans l’IA. Pour les créateurs, il s’agit ainsi de savoir si leur travail est exploité dans un contexte qu’ils n’ont pas approuvé.

Voici donc les principaux intérêts pour les utilisateurs :

Ces ensembles de données incluent de nombreuses images protégées par des droits d’auteur. Certains créateurs refusent que l’on utilise leur travail pour entraîner des modèles qui génèrent des œuvres dérivées.

Les données utilisées pour l’entraînement des modèles influencent directement leurs résultats. C’est pourquoi Have I Been Trained permet d’examiner la diversité (ou le manque de diversité) des ensembles de données, révélant des biais culturels, esthétiques ou géographiques.

Si un créateur découvre que ces ensembles incluent son travail, il peut entreprendre des démarches pour en demander le retrait. Bien que le site ne propose pas de fonctionnalité directe pour cela, il permet d’identifier les URL d’origine des images.

L’utilisation du site est simple et intuitive :

Bien que puissant, Have I Been Trained a ses limites :

Malgré ces limites, ce site représente une première étape majeure pour une IA plus éthique et responsable.

Have I Been Trained met en lumière une problématique clé dans le développement de l’IA : l’utilisation massive de données sans consentement explicite. Si les créateurs peuvent bénéficier des avancées technologiques de l’IA, il est essentiel que leurs droits soient respectés.

En permettant une transparence inédite, cette plateforme contribue ainsi de poser les bases d’un dialogue équilibré entre les créateurs, les développeurs et les utilisateurs d’IA. Que vous soyez artiste, photographe ou simplement curieux, ce site est une ressource précieuse pour comprendre l’impact des données dans l’ère numérique.

Si la protection de vos créations vous tient à cœur, Have I Been Trained est un outil incontournable. Afin de comprendre comment vos œuvres sont utilisées dans un monde toujours plus influencé par l’intelligence artificielle.

L’été est enfin arrivé, et avec lui, l’envie de se détendre sur des plages ensoleillées, ou de profiter de moments en famille à la montagne. Cependant, à l’ère des réseaux sociaux, où partager ses expériences et ses moments de bonheur est devenu une habitude. Il est essentiel de rester vigilant. Partager des informations sur vos dates de vacances peut sembler inoffensif. Mais cela peut en réalité vous exposer à des risques importants, notamment celui des cambriolages.

Lorsque vous partagez des informations personnelles telles que vos dates de départ en vacances ou votre emplacement actuel sur des plateformes comme Facebook, Instagram, ou autre, vous ne vous adressez pas seulement à vos amis et à votre famille. En fonction de vos paramètres de confidentialité, ces informations peuvent être accessibles à un public beaucoup plus large, y compris à des personnes mal intentionnées.

Les cambrioleurs modernes utilisent de plus en plus les réseaux sociaux pour repérer les maisons inoccupées. Savoir que vous serez absent pendant une période donnée peut les inciter à cibler votre domicile. C’est pourquoi il est crucial de faire preuve de prudence et de discrétion en ligne.

Pour vous aider à passer des vacances sereines et sans mauvaises surprises, voici quelques conseils pratiques par l’agence Lapostolle :

Partager les moments inoubliables de vos vacances avec vos proches est tout à fait naturel. Cependant, il est beaucoup plus sûr de le faire après votre retour. Vous pourrez ainsi profiter pleinement de votre voyage sans avoir à vous soucier de la sécurité de votre domicile.

Rappelez-vous que la prudence est de mise, surtout à l’ère numérique où les informations circulent rapidement et peuvent être exploitées par des personnes mal intentionnées.

Toute l’équipe de l‘Agence Lapostolle vous souhaite un été rempli de découvertes, de détente, et de moments précieux en famille ou entre amis. Profitez de chaque instant, et n’oubliez pas de rester vigilant quant à la protection de votre domicile.

Vous êtes-vous déjà demandé pourquoi votre boîte de réception ressemble parfois à une poubelle remplie de messages louches ? Ou pourquoi des inconnus vous proposent soudainement de partager leur héritage royal ? Eh bien, ne cherchez pas plus loin que les arnaques du web ! Ces escroqueries en ligne se cachent derrière des écrans d’ordinateur, attendant de piéger les internautes inattentifs. Dans cet article, nous allons explorer certaines des arnaques les plus courantes sur le web. Mais aussi, vous donner des conseils pour les éviter.

Préparez-vous à découvrir le monde fabuleux des escroqueries en ligne.

Si une offre en ligne semble trop belle pour être vraie, elle l’est probablement. Que ce soit un site web vendant des produits de luxe à des prix ridiculement bas. Ou une opportunité d’investissement promettant des rendements incroyables avec zéro risque, soyez méfiant. Ou alors, faites des recherches approfondies, lisez les avis et n’oubliez pas la vieille maxime. « Si cela semble trop beau pour être vrai, c’est probablement le cas. »

Aussi, il y a le phishing qui est une technique d’arnaque courante où les escrocs envoient des e-mails prétendument de grandes entreprises ou institutions. Vous demandant de fournir des informations personnelles sensibles, telles que des mots de passe ou des numéros de carte de crédit. Ces e-mails peuvent sembler authentiques, mais ne cédez pas à la panique. Vérifiez toujours l’adresse e-mail de l’expéditeur, et si quelque chose semble suspect. Contactez directement l’entreprise par un autre moyen pour confirmer la légitimité de la demande. Ou rendez-vous directement sur le site via votre navigateur, comme vous le feriez habituellement (sans passer par les liens dans l’e-mail).

Donc, vous avez apparement rencontré l’amour de votre vie en ligne, mais cette personne vit à l’étranger et a besoin d’argent pour vous rejoindre ? C’est peut-être une belle histoire, mais c’est aussi une arnaque romantique classique. Les escrocs ciblent souvent les gens vulnérables émotionnellement et utilisent des histoires d’amour pour extorquer de l’argent. Soyez prudent, et n’envoyez jamais d’argent à quelqu’un que vous n’avez pas rencontré en personne.

Si ce sujet vous intéresse ou vous interpelle nous vous invitons à regarder les vidéos du youtubeur « Le Radis Irradié » qu’il a fait à ce sujet. Les techniques de ces arnaques y sont détaillés et parfaitement expliqués.

Aussi, recevoir un appel d’un prétendu technicien informatique vous informant que votre ordinateur est infecté par des virus peut être très effrayant. Surtout, ne paniquez pas ! Les escrocs de support technique tentent souvent de vous convaincre d’installer un logiciel malveillant ou de leur donner un accès à distance à votre ordinateur. Si vous avez un problème informatique, contactez directement le support technique de la société concernée.

Alors oui, la recherche d’un emploi en ligne est un terrain fertile pour les escrocs. Méfiez vous des offres d’emploi qui semblent trop faciles à obtenir, qui vous demandent de payer pour travailler, ou qui nécessitent de divulguer des informations personnelles sans raison apparente. Faites des recherches sur l’entreprise et assurez vous qu’elle est légitime avant de postuler.

En conclusion, le web est un endroit merveilleux, mais il est également rempli de personnes malveillantes cherchant à vous arnaquer. Soyez vigilant, faites preuve de bon sens et n’oubliez jamais que si quelque chose semble louche. Il vaut mieux être prudent. En évitant ces arnaques courantes, vous pourrez surfer sur Internet en toute tranquillité, le sourire aux lèvres, en laissant les escrocs dans leur coin sombre du web, à la recherche de proies plus faciles. Bref, restez en sécurité et profitez de la magie du monde virtuel !

Tout d’abord, bien choisir ses mots de passe n’est pas si facile que ça en a l’air. De plus, on n’a pas forcément le temps de se creuser la tête pour trouver la bonne suite de caractères. Mais aussi, il faut savoir qu’il y a quand même des travers dans lesquels il ne faut surtout pas tomber, lorsque vous choisissez un mot de passe.

NordPass a dévoilé son étude annuelle sur ceux qui sont les plus utilisés dans le monde et l’évaluation de leur sécurité. Le but est de sensibiliser les utilisateurs à propos du choix de leur sécurité.

En 2022, le bilan reste assez identique aux années précédentes. Les mots de passe les plus utilisés sont faibles. Le top 10 montre une majorité qui sont facilement déchiffrables par des personnes malintentionnées. À commencer par la fameuse suite de chiffres 123456. Qui reste le mot de passe le plus choisi par les français et l’un des moins sécurisés…

Voici le top 10 de ceux les plus utilisés en France :