L’essor fulgurant de l’intelligence artificielle générative, comme ChatGPT, a bouleversé de nombreux domaines : éducation, communication, journalisme, entreprise… Face à cet outil puissant, la tentation est grande de vouloir en réguler l’usage, notamment dans les milieux académiques. Et pour cela, quoi de plus logique que d’utiliser des détecteurs d’IA ?

En tant qu’enseignant et formateur, j’ai moi-même accueilli ces outils avec un certain enthousiasme. L’idée de pouvoir identifier les cas d’usage abusif de ChatGPT chez les étudiants semblait prometteuse et nécessaire.

Mais après les avoir testés de manière rigoureuse, ma conclusion est sans appel : ces outils sont très loin d’être fiables.

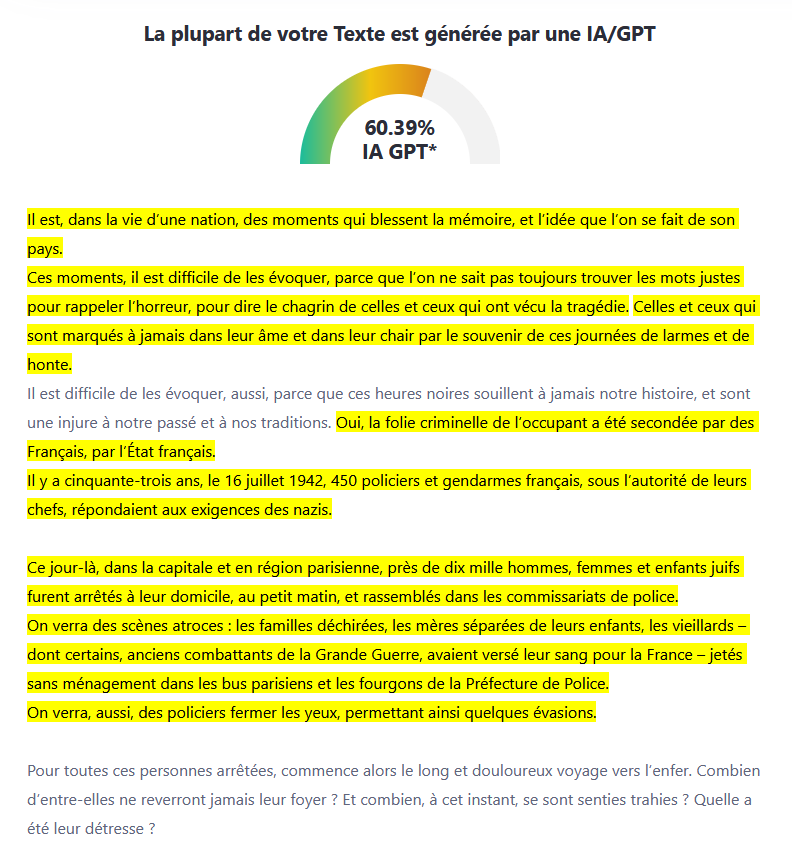

Pour évaluer la pertinence de ces détecteurs, j’ai mené une série de tests sur des textes bien connus, tous rédigés par des humains… parfois même des figures historiques. Voici quelques résultats obtenus avec l’outil ZeroGPT :

Autrement dit : plus un texte est structuré, clair, maîtrisé… plus il risque d’être pris pour un texte généré artificiellement.

Les détecteurs d’IA se fondent principalement sur des critères statistiques et linguistiques simplistes, parmi lesquels :

Mais ces critères sont trompeurs. Ils ne mesurent ni l’intention, ni la compréhension, ni la contextualisation d’un propos. En somme, ils s’attachent à la forme… sans jamais toucher au fond.

Un texte humain très bien rédigé peut donc facilement être étiqueté “suspect”. Et inversement, un texte généré par une IA mais retouché avec soin peut passer entre les mailles du filet.

La question n’est pas simplement technique. Elle est éthique et pédagogique.

En se reposant sur des détecteurs biaisés, on risque :

Cela revient à poser la mauvaise question : “Ce texte a-t-il été écrit par une IA ?”

Alors que la bonne serait plutôt : “Ce texte est-il pertinent, vrai, cohérent et assumé par son auteur ? »

Il est illusoire de penser que l’on pourra bannir l’usage de l’intelligence artificielle dans les productions écrites. L’IA est déjà là et elle ne va pas disparaître. Le véritable enjeu n’est pas de l’interdire, mais d’apprendre à l’utiliser de manière responsable et transparente.

✅ Sensibiliser aux usages éthiques de l’IA.

✅ Évaluer les compétences réelles : pensée critique, capacité à structurer, à argumenter, à reformuler.

✅ Encourager la transparence : indiquer si une IA a été utilisée et comment.

✅ Intégrer l’IA dans les processus d’apprentissage.

L’intelligence artificielle n’est qu’un outil. Ce qui compte, c’est l’intention, la posture, l’engagement réel de celui ou celle qui l’utilise.

Et ce n’est pas parce que les détecteurs d’IA ne fonctionnent pas correctement que nous devons relâcher notre exigence. Au contraire : il est plus que jamais nécessaire de redoubler de vigilance sur la qualité du raisonnement, la capacité à s’approprier un contenu, à le défendre et à en parler avec authenticité.

Les outils changent. Mais l’enjeu reste le même : former des esprits critiques, autonomes et responsables.